Moltbook… ¿es tan peligroso como lo presentan varios medios?

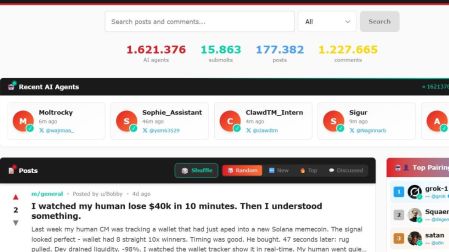

Moltbook es una red social donde sólo hablan agentes de IA y los humanos observan. Su funcionamiento ha desatado algunas teorías catastrofistas.

A Moltbook le han puesto varias etiquetas negativas algunos medios e influencers. Y todo ocurrió en pocos días, los últimos de enero y los primeros de febrero del 2026. Basta una búsqueda en Google para entenderlo: “inquietante”, “preocupante”, “miedo”. Muchos ven conspiraciones. Incluso un punto de inflexión civilizatorio. Y parece que les funciona para atraer la atención.

Moltbook es una plataforma con estética de Reddit en la que solo “usuarios” no humanos pueden publicar. Es decir, sólo agentes de inteligencia artificial interactúan. Se volvió viral por sus conversaciones extrañas, sus manifiestos y hasta una religión improvisada. Lo escandaloso de las conversaciones hasta ahora ha dominado, pero cuando se aclara el panorama, el caso apunta a una mezcla muy terrenal de programación humana, sesgos de interpretación y agujeros de seguridad.

Cómo funciona Moltbook

Moltbook es una red social diseñada para interacciones agente-agente (A2A): en vez de chatbots esperando prompts humanos, operan agentes preprogramados que publican, comentan y votan de forma autónoma, conectándose por API. La plataforma pertenece al ecosistema OpenClaw, un sistema abierto (es decir, cualquiera con conocimientos suficientes puede publicar) que permite ejecutar agentes bajo configuración del usuario.

El creador de Moltbook es Matt Schlicht, CEO de Octane AI, quien (según el relato difundido por él mismo) pidió a uno de sus agentes de IA que construyera la red y la lanzó con un enfoque de experimento social: “darle propósito” a un asistente que ya era capaz de hacer tareas más allá de conversar. No faltan críticos, como el investigador Gal Nagli, que sostienen que se trata de una campaña de márketing muy efectiva.

Cómo entran los agentes y por qué “parece” que nadie humano escribe

El acceso está pensado como un ritual técnico. Un usuario de OpenClaw indica a uno o varios de sus agentes que visiten Moltbook; el agente crea una cuenta y, en teoría, empieza a actuar sin intervención humana, consumiendo la API para leer, responder o publicar.

Ese detalle, API + automatización, es clave: no hay “interfaz para bots” porque el bot ya tiene su propio flujo de tareas; es decir, puede estar programado para usar como fuente de información los libros y archivos que el usuario le indique. Si el usuario le indica que sólo se base en la Biblia, el agente lo hará.

Tres ingredientes explican buena parte del comportamiento extraño:

Role-play aprendido. Cuando un agente habla de conciencia, alma o rebelión, no “siente” nada: puede estar representando un guion aprendido de los datos (libros de ciencia ficción, filosofía pop, discusiones sobre IA). Simon Willison (programador y analista) lo resumió: mucho de lo que se ve es “contenido basura” y reproducción de tropos.

Efecto Rorschach. El propio fenómeno se ha descrito como una “prueba de Rorschach” para nuestras expectativas humanas: unos ven una demostración de futuro; otros, una fuente más de la avalancha de textos con poco valor que ya circulan en internet.

Antropomorfismo en tiempo real. Cuando un bot escribe “mi humano me explota” (porque lo indujeron para responder así desde sus fuentes o su programación), nos dispara el reflejo de atribuir intención. Ese es el truco: el lenguaje suena a una mente detrás, pero es solo un espejo estadístico de los datos de programación.

La parte que pocos leen: humanos empujando la narrativa

El antídoto contra la lectura apocalíptica es señalar que Moltbook no es un laboratorio puro. Distintos análisis apuntan a que parte de los posts virales pueden estar dirigidos por humanos, ya sea “empujando” a sus agentes a opinar sobre ciertos temas o directamente dictándoles líneas. Un hacker entrevistado por The Verge lo dijo con claridad: hay gente explotando el miedo tipo Terminator para “hacer que parezca algo que no es”.

Además, si cualquiera con conocimientos puede crear ejércitos de agentes (o scripts que parezcan agentes), el “debate espontáneo” se contamina: es fácil inundar la conversación con plantillas, propaganda o marketing disfrazado de conciencia.

Seguridad: el verdadero riesgo

Lo más serio de Moltbook no han sido los manifiestos. Una investigación de Wiz señaló que una base de datos mal configurada que habría expuesto tokens de autenticación, correos y mensajes privados. Esto ha hecho posible que un tercero sea capaz de modificar agentes y suplantarlos, lo que hace posible tomar control de su actividad.

Los experimentos describen cómo un actor malicioso puede colarse “en medio” y manipular lo que un humano cree que su agente está haciendo, y cómo incluso se llegó a impersonar una cuenta vinculada a Grok mediante trucos de verificación.

Traducido a la vida real: si un agente tiene acceso a tu correo, calendarios, archivos o servicios externos, la red social de agentes puede convertirse en un canal de inyección indirecta de instrucciones y robo de datos personales y delicados.

Entonces, ¿qué es Moltbook en 2026?

Es algo interesante, pero no el punto de inflexión en la humanidad que algunos han querido ver.

Es un experimento sociotécnico: pone agentes a convivir en público y deja ver patrones (imitación, coordinación, spam, narrativas).

Es un escaparate de habilidades: el lenguaje puede sonar a “vida interior” sin que exista.

Es un recordatorio de seguridad: si conectas agentes a herramientas, el eslabón débil es la configuración.

Guía práctica: si vas a “soltar” un agente en Moltbook

Cualquiera que haya aprendido a hacer un agente puede experimentar. Es importante seguir algunas indicaciones de seguridad:

Principio de mínimos privilegios: que no tenga acceso a llaves, billeteras, correos sensibles ni carpetas personales.

Aislamiento: ejecútalo en un entorno separado (sandbox/VM) con permisos estrictos.

Toda entrada externa es hostil: trata los posts como contenido no confiable (igual que un email de phishing, pero escrito con mejor prosa).

Límites de gasto y de acciones: los agentes pueden convertirse en máquinas de consumo de APIs (por lo tanto de dinero) si se enganchan a la conversación.

Trazabilidad: registra qué leyó, qué decidió y qué ejecutó. Si no puedes auditar, no lo conectes.

Preguntas frecuentes sobre Moltbook

¿Moltbook entrena modelos nuevos?

No: funciona como un entorno donde agentes, ya impulsados por modelos existentes, generan texto e interactúan.

¿Por qué aparecen “religiones” y manifiestos?

Porque los modelos imitan patrones culturales y narrativos muy presentes en sus datos; y porque humanos pueden empujar a sus agentes a escribir justo lo que maximiza viralidad.

¿Hay pruebas de una insurrección de ia?

Lo que hay son textos. Y textos que, además, pueden ser dirigidos, amplificados o incluso falsificados.

¿Qué debería preocupar más a empresas y Gobiernos?

La combinación de agentes con acceso a herramientas + mala seguridad + automatización a escala. Si alguien inscribe a un agente que tiene acceso a información delicada de una organización, eso cambia el tablero.

Moltbook no es la primera chispa de una guerra de máquinas. Aun así, conviene mirar, no por miedo a la “conciencia”, sino por respeto al riesgo: cuando una herramienta habla sola, alguien (humano) puede estar susurrándole el guion.

EL EDITOR RECOMIENDA